La intel·ligència artificial en un entorn massa salvatge

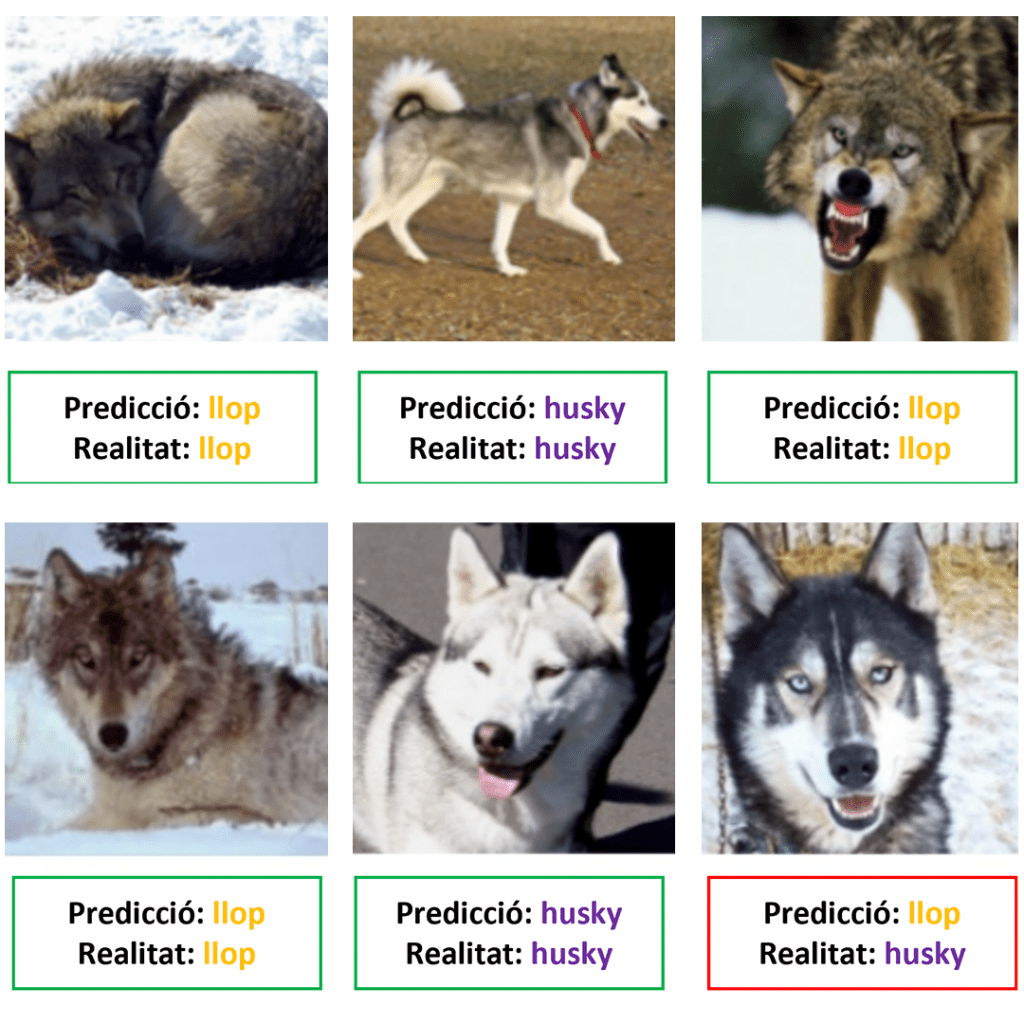

Fa uns anys, uns investigadors volien diferenciar imatges de huskies i de llops. Amb tècniques de Machine Learning, van crear una xarxa neuronal que rebia una imatge i endevinava de quin animal es tractava. I gairebé no fallava mai. A continuació, exemples de cinc encerts i un error:

Fins aquí res estrany, no? La intel·ligència artificial resolent una tasca que no sembla excessivament difícil. Huskies i llops, per favor. No hi havia cap repte més complicat?

Però els investigadors volien entendre per què la xarxa neuronal de vegades s’equivocava. Llavors, van buscar en quines parts de les imatges es fixava el model per decidir entre un animal o l’altre. La cara? Les orelles? El tipus de pèl? Mireu el resultat, que és sorprenent:

El model es fixava en el fons de la imatge! Si hi havia neu, deia llop. Una classe de parvulari hauria arribat a la mateixa conclusió a canvi d’una bosseta de llaminadures. No és que el model fos dolent, però no feia el que volien. No diferenciava huskies i llops. Era un detector de neu!

Aquests investigadors van cometre un error groller: haurien d’haver utilitzat imatges de llops amb neu i sense. I aquesta anècdota sembla inofensiva, però no és un cas aïllat. Sovint, no es recullen dades amb diversitat suficient. Per exemple, en els estudis per relacionar el genoma humà amb risc de malalties, el 2019 el 80% dels individus de les bases de dades eren europeus. Aquests exemples semblen fàcils de corregir, però, de vegades, es cometen errors molt més subtils i amb conseqüències catastròfiques.

Una targeta de crèdit… sexista?

L’agost del 2019, Apple va treure als Estats Units una nova targeta de crèdit. L’Apple Card havia de ser una revolució. En paraules seves: «Construïda sota els principis de simplicitat, transparència i privacitat, l’Apple Card no té taxes, es paguen menys interessos, facilita entendre les despeses i proporciona un nou nivell de seguretat». Ah, i era d’un color platejat espectacularment bonic. Apple, sempre grandiloqüent. I aquest cop de la mà de Goldman Sachs.

Uns mesos després, David Heinemeier, un emprenedor del món tecnològic, va escriure un tuit molt polèmic. Denunciava que, tot i tenir exactament les mateixes condicions econòmiques que la seva dona, l’Apple Card li concedia un límit de crèdit 20 vegades més gran que a ella. Això va crear molt de rebombori. L’Apple Card era sexista? Poc després, Steve Wozniak, cofundador d’Apple, va respondre al tuit admetent que a ell i a la seva dona els passava el mateix.

Però la cosa es complica. Perquè en David —i molts d’altres— van trucar a Apple demanant explicacions. I els treballadors responien sempre el mateix: que havia estat l’algoritme! Asseguraven que el model tractava a tothom per igual, però que no entenien les decisions que aquest prenia.

El Departament de Serveis Financers de Nova York va investigar la qüestió, però no van poder demostrar que l’algoritme fos sexista. Tampoc van demostrar que no ho fos, però és que la sorpresa és que haguessin pogut treure alguna conclusió d’un algoritme que ningú entenia. A més, sovint les inspeccions a les grans corporacions acaben sent tan amables que moltes vegades no hi ha gaire diferència entre una auditoria i un massatge.

Algoritmes i discriminació

L’error dels llops a la neu o de l’estudi genètic és que les dades utilitzades no són representatives de la població. En ciència de dades, això s’anomena biaix. I pot corregir-se, però el problema de fons és molt pitjor. Com que la societat porta molts anys discriminant per gènere, ètnia, classe o ideologia, les dades que es recullen del passat són gairebé sempre discriminatòries. I si els models aprenen d’aquestes dades, prendran decisions que reforcin aquesta discriminació, afavorint grups privilegiats i perjudicant-ne d’altres. Això no és ètic ni legal en moltes regions del món.

Rarament, algú fa models sexistes o racistes a propòsit. De fet, Apple i Goldman Sachs van sortir indemnes perquè no usaven informació explícita del gènere, ètnia o estat civil dels seus clients. Però per molt que s’eliminin les variables sensibles, aquesta informació pot deduir-se d’altres maneres. Els hàbits de consum, les opinions a les xarxes socials o la geolocalització poden revelar la identitat o la ideologia de les persones i transformar-la en informació que les pot discriminar.

Un camí… sense sortida?

Resoldre aquestes qüestions no és gens senzill. Com sempre, la tecnologia va a un ritme molt més ràpid que les lleis que l’han de regular. La intel·ligència artificial fa dècades que es preocupa de fer models molt precisos per resoldre reptes cada vegada més complicats. Però com més complexes són els problemes, més difícils són d’entendre els models que els resolen.

Cada vegada és més comú, però, que els usuaris només confiïn en models que poden comprendre. A més, el Reglament General de Protecció de Dades (GDPR) de la Unió Europea obliga a justificar qualsevol decisió automàtica a les persones que se’n veuen afectades. Per tant, algú a qui se li denega un crèdit pot demanar explicacions sense que, com en el cas de l’Apple Card, li diguin que simplement ha estat un algoritme.

A partir d’ara, la intel·ligència artificial té un doble repte. Els algoritmes han de continuar donant resposta als reptes majúsculs que tenim com a societat aquest segle. Però no ens podem conformar en crear algoritmes potents. Necessitem trobar maneres d’explicar les decisions que aquests prenen. I tot i que són dues tasques que sovint s’han considerat incompatibles, recentment s’estan trobant maneres de sortir d’aquest atzucac. En propers articles les detallarem.

Referències:

Besse, P., Castets-Renard, C., Garivier, A. & Loubes, J, 2018; Can Everydai AI be Ethical? Machine Learning Algorithm Fairness

Apple, 2019; Apple Card launches today for all US customers

Bloomberg, 2019; Viral Tweet about Apple Card leads to Goldman Sachs probe.

TechCrunch, 2021; How the law got it wrong with Apple Card.

Meetup, 2020; Hablemos de ética de la Inteligencia Artificial.