Sovint costa d’entendre per què tanta gent no pensa com nosaltres, si constantment veiem notícies i dades a la xarxa que demostren que tenim raó. La resposta és senzilla: ells no veuen la mateixa informació. Veuen opinions d’ideologia contrària que també els donen la raó i, per tant, és improbable que ens posem d’acord.

Mires a l’altra banda i penses: com tota aquesta gent pot ser tan estúpida? Mira tota aquesta informació que estic veient constantment. Com pot ser que no l’estiguin veient? La resposta és simple: ells no l’estan veient.

El dilema social, Netflix

Les xarxes socials estan dissenyades perquè interaccionem amb el contingut. No importa que sigui de qualitat, ni tan sols que sigui cert. Només que hi cliquem, reaccionem i el compartim. Els algoritmes calculen la probabilitat que interaccionem amb una publicació i, si és alta, ens l’ensenyen. Per què? Si passem més temps a la plataforma, ells guanyen més diners en publicitat.

Normalment, és més probable que reaccionem quan percebem una amenaça. Per això, els influenciadors i els polítics tenen discursos sensacionalistes i hostils. Hi ha evidències que les xarxes han escampat notícies falses, radicalitzat la població i incitat a la violència: l’assalt al Capitoli, la guerra civil a Sudan del Sud… Es ressalten missatges inflamatoris, fent enfadar la població i incrementant el risc que les diferències socials acabin en violència.

Algoritmes pont

Les xarxes socials actualment divideixen i polaritzen. Però per què hauríem d’acceptar que siguin així per defecte? Per sort, fa poc va sorgir una alternativa esperançadora: els algoritmes pont.

La bretxa de percepció és la diferència que percebem entre les creences dels altres respecte a les seves creences de veritat. Quan discutim, normalment no ho fem contra l’altre bàndol, sinó contra la imatge que tenim d’ell.

Imagineu que les plataformes prioritzessin el contingut que posés d’acord diferents grups d’opinió. Els algoritmes pont (bridging algorithms) són un mètode alternatiu que funcionen amb aquest propòsit, promocionant el debat i l’acord entre diferents perspectives i fent-nos veure que, probablement, els valors dels altres són molt més semblants als nostres del que ens pensem.

Com funcionen?

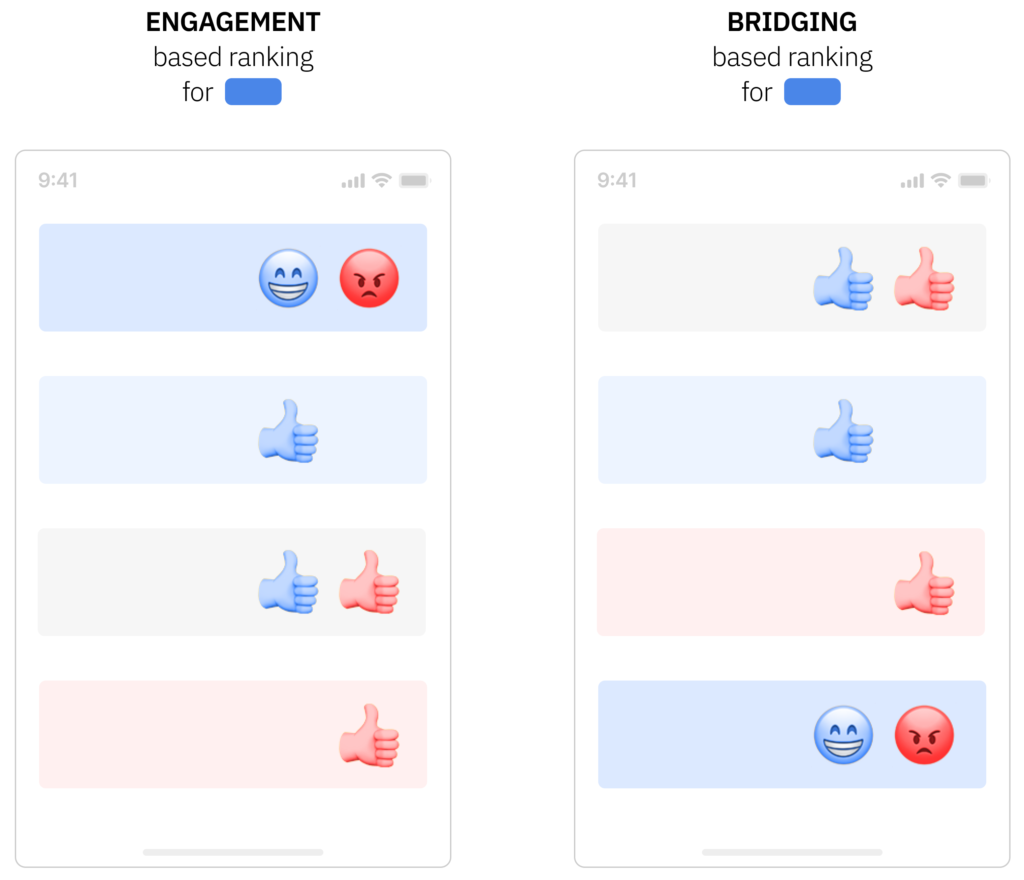

A la imatge de sota, a l’esquerra, veiem que els sistemes actuals prioritzen contingut que més agrada a usuaris similars, independentment dels usuaris de perfils diferents. Els algoritmes pont també ensenyen publicacions que agraden als usuaris, però prioritzen les que, a més, agraden a l’altre bàndol, deixant el sensacionalisme en últim lloc.

Com podem veure a la imatge de sota, es prioritza contingut:

- Que tenen una distribució de reaccions no polaritzada.

- Aprovat per persones que normalment estan en desacord amb l’autor.

- O quan gent consulta fonts que normalment no veuen.

Posem-ho en pràctica

Si això us sona a utopia, bones notícies! Ja hi ha precedents exitosos. Per exemple, les «notes de la comunitat» a X, que identifiquen tuits enganyosos: tan sols es publiquen notes valorades positivament per individus d’opinions diferents.

El 2015, per saber l’opinió pública sobre UberX, el govern de Taiwan va usar Polis, una eina d’enquestes que identifica missatges amb el grau més gran d’acord entre persones que normalment opinen diferent.

Facebook va fer experiments amb algoritmes pont, on millorava significativament la qualitat del contingut, molt menys probable de ser reportat per assetjament, odi o incitació a la violència. Malauradament, aquests tipus de canvis comporten una caiguda inicial d’usuaris, fins que amb el temps s’hi acaben acostumant i els agrada més. El problema? Les empreses es fan enrere abans d’observar els beneficis a llarg termini.

Com que, avui en dia, les big tech no s’esforcen per contrarestar la polarització, les lleis les haurien d’obligar o incentivar. Els algoritmes s’han de regular com qualsevol altre àmbit, perquè ens afecten i molt.

A més, les big tech tindrien altres beneficis. Si hi ha menys incentius per generar toxicitat, es reduirà el cost de la moderació. Probablement, reduirien danys reputacionals i legals. Per exemple, Facebook ha estat demandat per incitar a la violència a Myanmar, Sri Lanka i Etiòpia per valor de 150 bilions de dòlars.

Reptes

És important que hi hagi conflicte, perquè és una forma d’aconseguir que la societat millori. L’objectiu dels algoritmes pont no és eliminar el desacord, sinó promoure formes constructives de conflicte entre els que pensen diferent. A més de mitigar els riscos de les disputes més perilloses.

Lògicament, cap solució és perfecta. Aquest sistema funciona millor amb qüestions de resposta oberta que preguntes de sí o no o en temes amb posicions molt marcades.

Què passa, per exemple, si gent de diferents ideologies comparteixen un prejudici sobre una minoria? Probablement, s’hauran d’afegir restriccions específiques per evitar conseqüències indesitjables, ja que no es tracta de promoure contingut aprovat per la majoria, sinó per audiències diverses.

Si la nostra societat no divideix per defecte, les xarxes tampoc ho haurien de fer. Tant les companyies tecnològiques com els usuaris les hem de modelar de forma ètica, amb sentit comú i auditoria democràtica, per crear comunitats en línia que reflecteixen el millor de nosaltres. Per primer cop, hem trobat una via que trenca el dogma que les xarxes socials només poden polaritzar. Les eines ja les tenim. Ara tan sols hem d’atrevir-nos a fer-les servir.

Referències

La imatge de l’article ha estat generada amb Copilot Designer, eina d’Intel·ligència Artificial Generativa de Microsoft

Sieker, F; Bertelsmann Stiftung; 2024. Construir ponts en lloc de polaritzar.

Grant, A; Raskin, A; WorkLife; 2024. Reimaginant la tecnologia i parlant als animals.